要想通过学习神经网络的参数来得到优质的人脸图片编码,方法之一就是定义三元组损失函数然后应用梯度下降

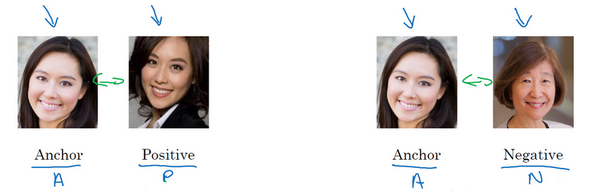

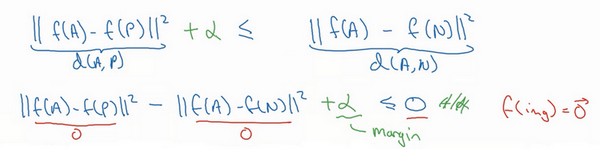

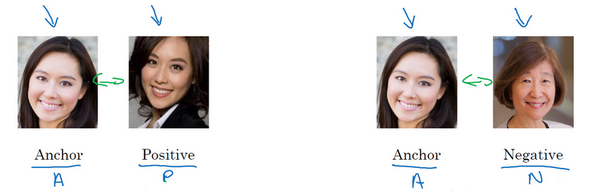

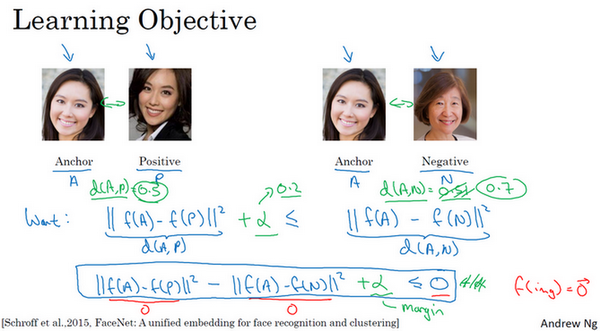

三元组损失每个样本包含三张图片:靶目标(Anchor)、正例(Positive)、反例(Negative),简写成A、P、N

网络的参数或者编码应满足:

让∣∣f(A)−f(P)∣∣2很小,即:

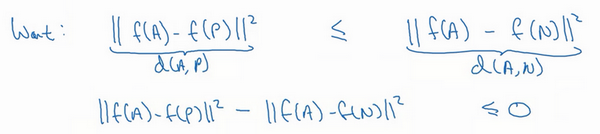

∣∣f(A)−f(P)∣∣2≤∣∣f(A)−f(N)∣∣2 ∣∣f(A)−f(P)∣∣2−∣∣f(A)−F(N)∣∣2≤0 ∣∣f(A)−f(P)∣∣2)是d(A,P),∣∣f(A)−f(N)∣∣2是d(A,N)

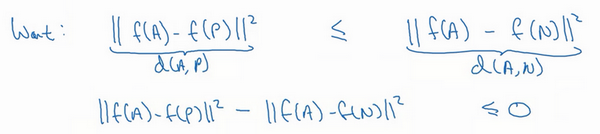

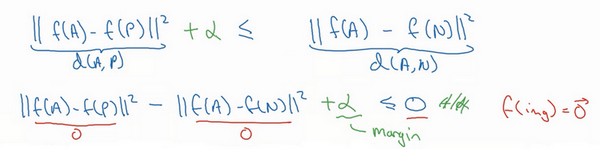

如果所有的图片都是零向量,即f(A)=0,f(P)=0,f(N)=0那么上述不等式也满足。但是对进行人脸识别没有任何作用,所以添加一个超参数α,且α>0,对上述不等式做出如下修改:

∣∣f(A)−f(P)∣∣2−∣∣f(A)−F(N)∣∣2≤−α ∣∣f(A)−f(P)∣∣2−∣∣f(A)−F(N)∣∣2+α≤0

间隔参数α也被称为边界margin,类似于支持向量机中的margin,拉大了Anchor和Positive图片对和Anchor与Negative图片对之间的差距。若d(A,P)=0.5,α=0.2,则d(A,N)≥0.7

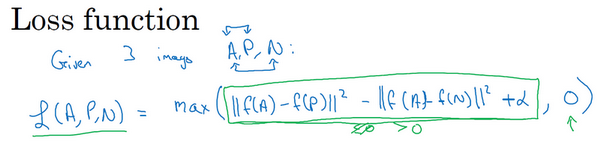

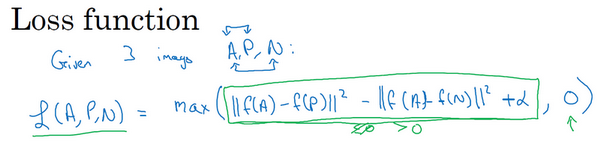

损失函数的定义基于三元图片组,即取这个和0的最大值:

L(A,P,N)=max(∣∣f(A)−f(P)∣∣2−∣∣f(A)−f(N)∣∣2+α,0) max函数的作用是只要∣∣f(A)−f(P)∣∣2−∣∣f(A)−f(N)∣∣2+α≤0,损失函数就是0

如果∣∣f(A)−f(P)∣∣2−∣∣f(A)−f(N)∣∣2+α≤0,最终会得到∣∣f(A)−f(P)∣∣2−∣∣f(A)−f(N)∣∣2+α,即正的损失值。通过最小化这个损失函数达到的效果就是使这部分∣∣f(A)−f(P)∣∣2−∣∣f(A)−f(N)∣∣2+α成为0,或者小于等于0

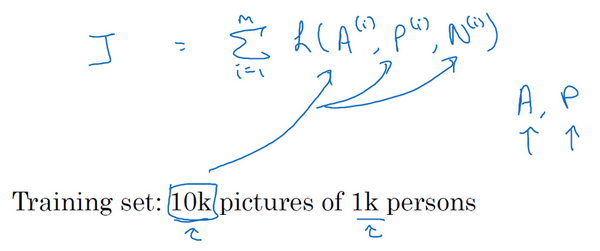

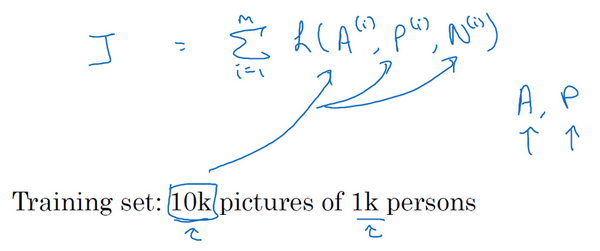

整个网络的代价函数是训练集中单个三元组损失的总和

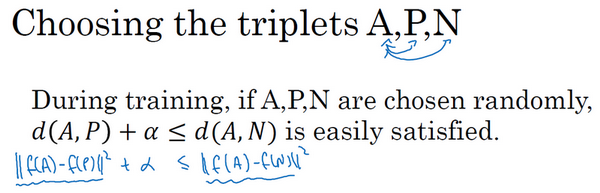

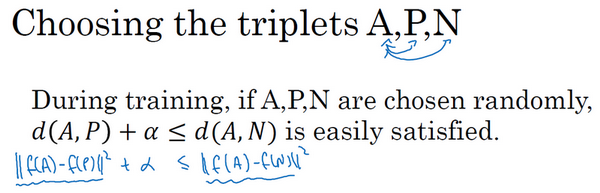

如何选择三元组来形成训练集:如果从训练集中随机地选择A、P和N,遵守A和P是同一个人,而A和N是不同的人这一原则。那么约束条件(d(A,P)+α≤d(A,N))很容易达到,因为随机选择的图片,A和N比A和P差别很大的概率很大,而且差距远大于α,这样网络并不能从中学到什么

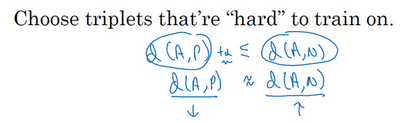

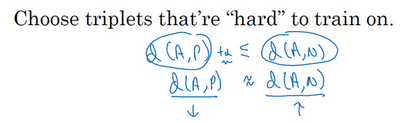

所以为了构建一个数据集,要做的就是尽可能选择难训练的三元组A、P和N:

想要所有的三元组都满足条件(d(A,P)+a≤d(A,N)),A、P和N的选择应使得d(A,P)很接近d(A,N),即d(A,P)≈d(A,N),这样学习算法会竭尽全力使右边式子变大(d(A,N)),或者使左边式子(d(A,P))变小,这样左右两边至少有一个α的间隔。并且选择这样的三元组还可以增加学习算法的计算效率

总结:

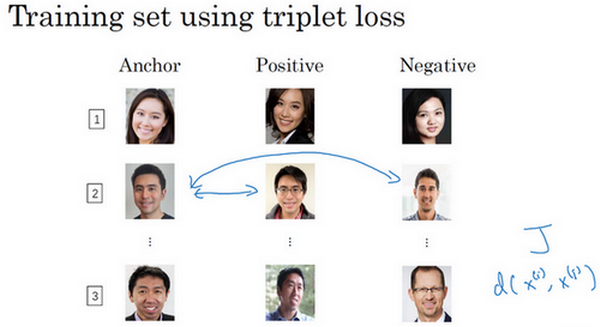

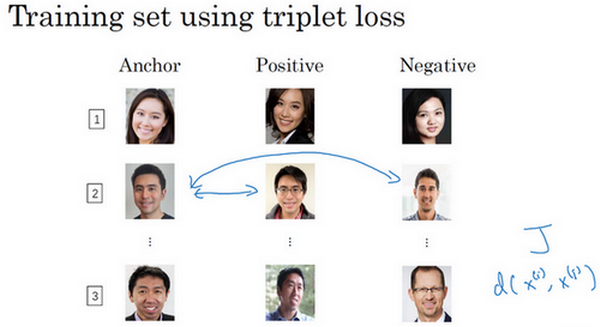

训练三元组损失需要把训练集做成很多三元组,这就是一个三元组(编号1),有一个Anchor图片和Positive图片,这两个(Anchor和Positive)是同一个人,还有一张另一个人的Negative图片。这是另一组(编号2),其中Anchor和Positive图片是同一个人,但是Anchor和Negative不是同一个人,等等。

定义了这些包括A、P和N图片的数据集之后,还需要用梯度下降最小化代价函数J,这样做的效果就是反向传播到网络中的所有参数来学习到一种编码,使得如果两个图片是同一个人,那么它们的d就会很小,如果两个图片不是同一个人,它们的d 就会很大