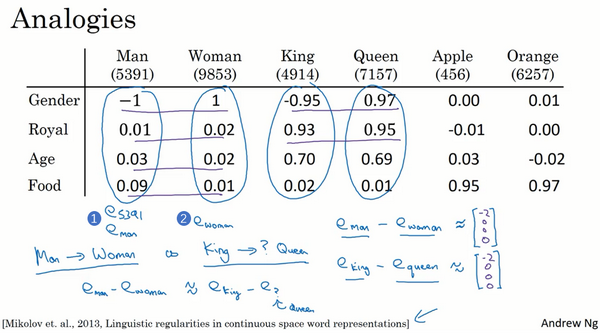

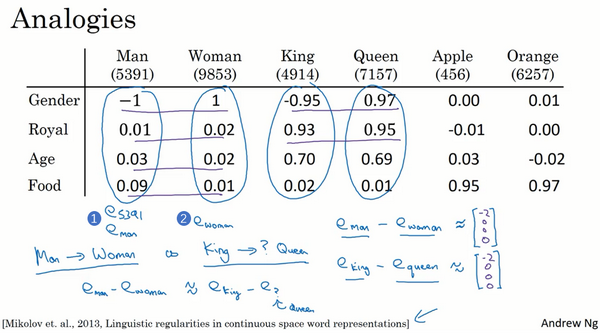

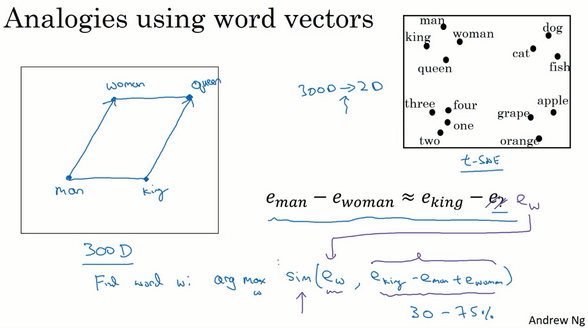

该例中,假设用的是四维的嵌入向量,假如向量eman和ewoman、eking和equeen 分别进行减法运算,相减结果表明,“Man”与“Woman”的主要区别是性别,“King”与“Queen”也是一样

所以当算法被问及man对woman相当于king对什么时,算法所做的就是计算eman−ewoman,然后找出一个向量也就是找出一个词,使得:

eman−ewoman≈eking−e? 即当这个新词是queen时,式子的左边会近似地等于右边

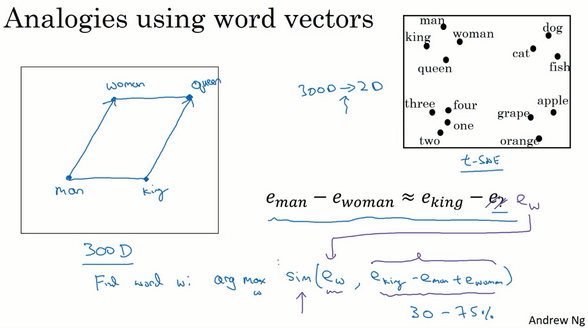

在图中,词嵌入向量在一个可能有300维的空间里,箭头代表的是向量在gender(性别)这一维的差,为了得出类比推理,计算当man对于woman,king对于什么,要做的就是找到单词w来使得

eman−ewoman≈eking−ew 等式成立,即找到单词w来最大化ew与eking−eman+ewoman的相似度,即

Find word w:argmax Sim(ew,eking−eman+ewoman) 即把ew全部放到等式的一边,另一边是eking−eman+ewoman。应用相似度函数,通过方程找到一个使得相似度最大的单词,如果结果理想的话会得到单词queen

t-SNE算法所做的就是把这些300维的数据用一种非线性的方式映射到2维平面上,可以得知t-SNE中这种映射很复杂而且很非线性。在大多数情况下,由于t-SNE的非线性映射,不能总是期望使等式成立的关系会像左边那样成一个平行四边形

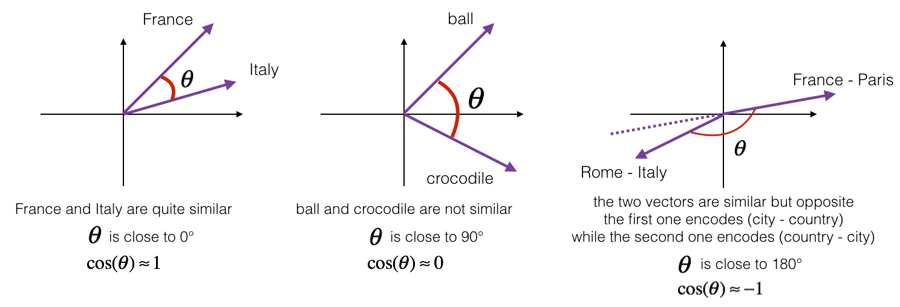

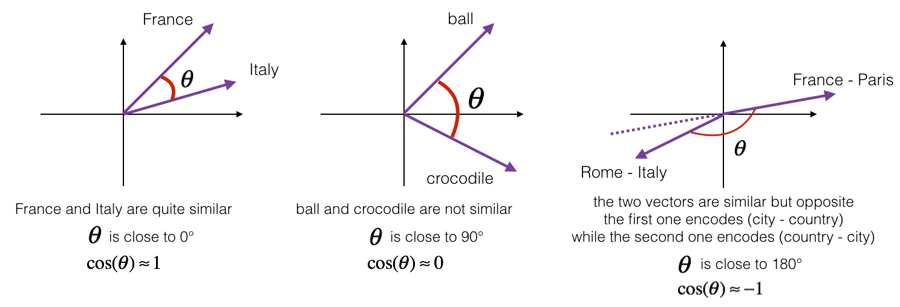

关于相似函数,比较常用的是余弦相似度,假如在向量u和v之间定义相似度:

Sim(u,v)=∣∣u∣∣⋅∣∣v∣∣uTv 分子是u和v的内积。如果u和v非常相似,那么它们的内积将会很大,把整个式子叫做余弦相似度,是因为该式是u和v的夹角的余弦值

参考资料: 给定两个向量u和v,余弦相似度定义如下:

CosineSimilarity(u,v)=∣∣u∣∣2∣∣v∣∣2u.v=cos(θ) u.v 是两个向量的点积(或内积),∣∣u∣∣2是向量u的范数(或长度), θ 是向量u和v之间的角度。这种相似性取决于角度在向量u和v之间。如果向量u和v非常相似,它们的余弦相似性将接近1; 如果它们不相似,则余弦相似性将取较小的值

两个向量之间角度的余弦是衡量它们有多相似的指标,角度越小,两个向量越相似

还可以计算Euclidian distance来比较相似性,即∣∣u−v∣∣2。距离越大,相似性越小